5月12日凌晨消息,Google I/O 2022开发者大会(后文简称谷歌I/O)今日开幕,本次大会采用线上+线下的形式,线下重新回到旧金山海岸线圆形剧场。在2小时的主题演讲上,谷歌重新梳理了自己现有AI,计算,数据模型的进度,并演示了关键技术应用。 并发布了两款新硬件,还官方提前曝光了未来三款硬件。

谷歌的两个使命和实现使命的工具

节目开始,开场视频提出了一系列问题,比如从A到B点怎么走最方便,怎么找到某个地方;之后给出答案“科技让所有人都过得更好,向努力创造未来”

谷歌CEO桑达尔·皮查伊(Sundar Pichai)走上舞台,感叹再次重回海岸线圆形剧场的美好。 他提到谷歌的两个使命,其一是深化对信息的理解,第二让人们无论在哪都能获得知识。

他以“谷歌翻译”作为开始 ,这次增加了24种翻译语言,它可以打破人们沟通障碍的方式,让人们得以将知识传播到更远的地方;至于“远方”,则自然联系到了谷歌地图(Google Maps),地图数据的提升,让非洲等偏远地区也能使用,3D绘图和机器学习等+航拍,让沉浸式实景地图更逼真完整。

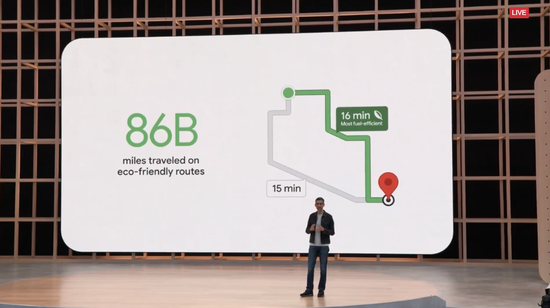

数据的使用,甚至可以让地图更环保:例如探索一些更好的路线,将行驶所需油耗降低,达到降低排放的目的。

作为视频平台,YouTube去年已经可以自动生成章节分段。现在通过语音/视频脚本分析等,让这种分段更准确,数量也会达到8千万段。

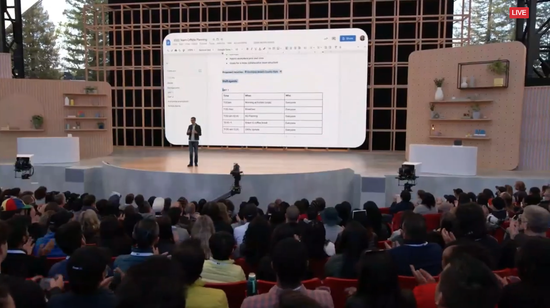

AI甚至能帮人工作,比如一个超长的工作文档,机器帮你总结它说了啥。

未来这个技术甚至会引入Google Chat,生成聊天摘要,或者在一大堆群聊中捡出重点信息。甚至AI可在视频对话时候自动改变光线,让视频看起来更清晰。

搜索的未来

谷歌最为出名的产品是搜索引擎,在之前,搜索是类似查询的方式,你输入,它给出一堆想噶结果;之后问题变得逐渐复杂,例如用户会上传一张图片,问这是什么鸟类?——这种问题不再是文字,也用到了谷歌图像识别技术。

不过这还不是终点。谷歌希望,在未来“用任何方式在任何地方进行搜索”。

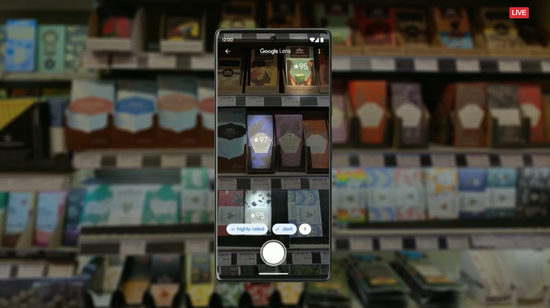

“多重搜索”是谷歌已经开始进行的工作,它利用AI多模态理解,去理解人们的搜索意图。并用直观的方式体现。

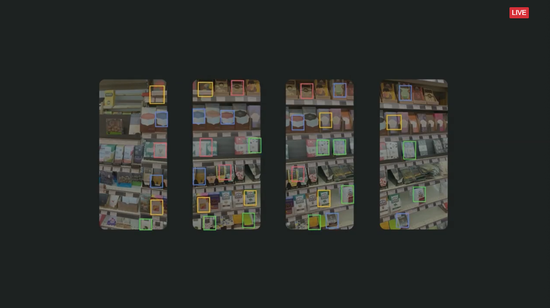

一个实例来说,在巧克力店去寻找“不含坚果黑巧克力”,用户要做的是采用手机镜头去扫描货架。镜头去识别物体-加入筛选条件-呈现出结果。

这是图像识别+筛选结果的过程,仍旧是一种搜索,但已经跟之前的搜索引擎体验完全不同。

整个体验我们以往理解的搜索很不一样,正是谷歌理解的“搜索”的未来。

谷歌讲将类似技术加上相应的肤色指南,便可去构建一个更具包容性的体验,比如为不同负责的人去匹配合适的彩妆或滤镜,这很政治正确。

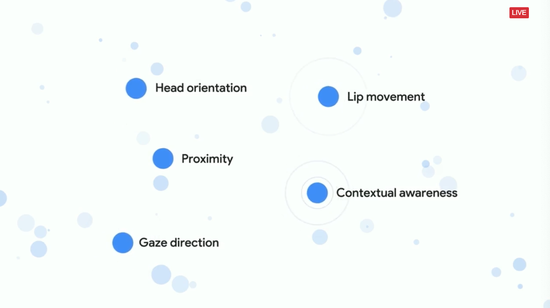

对用户来说,在消费级产品上的改进是更直接的,比如Nest Hub Max智能屏产品,谷歌为它引入的新功能的“Look and Talk”,也就是看着说就行。

演示的片段是“找出圣莫尼卡海滩”——智能屏给出相应图片——“第一个怎么走”——它给出路线。这过程更像人跟人之间的对话方式,更自然,因为机器会理解人说的“第一个”是啥。

另外,自然语言处理也更精准,比如对计算机说“找个那谁的什么歌”,虽然这并不是一个精准的需求,但机器会去掉中间的不清晰因素,给出准确的结果。

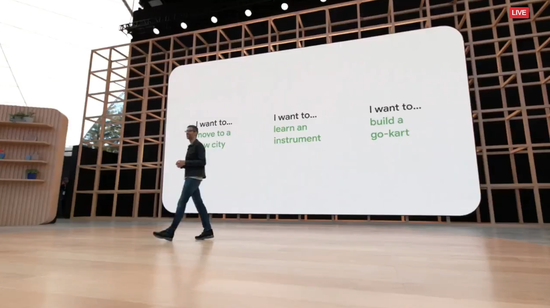

皮查伊回到舞台,再次讲起“LAMDA”的研究进展,去年谷歌I/O大会宣布的用于对话应用的语言模型。

学习概念在其中起到了至关重要的作用,LaMDA在对话过程中会不断理解,让后面对话进行下去,而不是每次中断,需要再次学习现在正谈什么。

今年的演示是“我想要种菜”,机器逐步给出各种指导。

这其实仍旧是搜索,LaMDA在背后进行一连串的搜索找答案的过程。只不过仿佛你真的在和一个有经验的人请教种菜的过程。

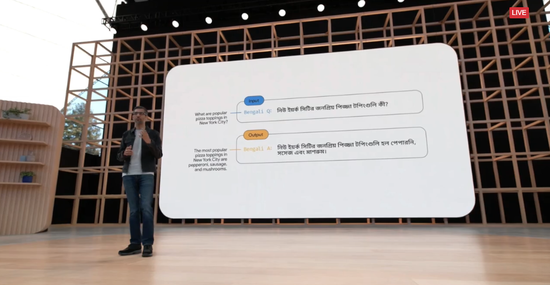

另外,谷歌引入了一个新的大型语言模型:通路语言模型(PaLM:Pathways Language Model),一个具有5400亿参数的Transformer(转换器)训练模型。

PaLM可以被训练使用英语和多语种数据集,在很多很困难的任务体现出更强的能力。例如,用孟加拉语问PaLM纽约最好的披萨在哪,这种跨语言的刁钻问题,展示的是非英语语言、编码和算术任务的熟练程度。

保护性计算

对多数用来说,以上的内容过于晦涩了。接下来是一些普通用户也能用到的东西,也展现了谷歌的数据保护。

比如Sign in with Google,国内用户可能在苹果设备上见过类似的东西了,简称账号打通。

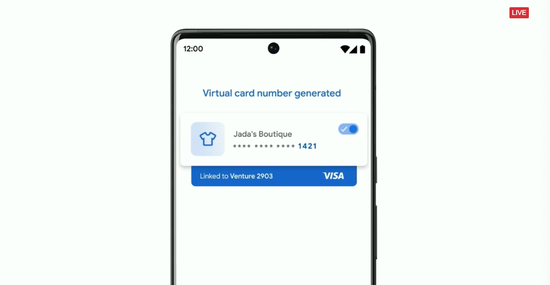

另外Google Pay付款时候,信用卡号会被保护起来(虚拟卡号),防止被盗。

谷歌的商业模式是广告,之前因为对用户数据的理解被外界批评。如今他们承诺对广告数据进行保护,例如不会利用用户的隐私/性取向等做广告线索。在“我的广告中心”,用户能控制一些自己的隐私。

如果用户发现搜索结果中包含自己的邮件,电话等,可以点击搜索结果申请删除。

Android 13更新重点平平无奇 谷歌重新重视平板系统

Android 13终于来了,开场三大主题:手机是中心,从手机向其他产品拓展,(多设备)更好的协同工作。

在谈过一些诸如多语言等基础功能后,重点到了RCSRich Communication Suite,融合通信)。其实之前谷歌已经开始推行通过Android Messages 向全球范围内所有安装了 RCS(Rich Communication Suite,融合通信)的用户提供RCS聊天服务,并将其作为默认的短信应用程序,类似于苹果的iMessage。

另一个改进是谷歌钱包,不止有卡,还有电子机票,车钥匙,甚至疫苗接种卡等更丰富的内容。

Android 13和手表的WearOS也加入了更多安全功能,例如呼叫紧急呼救,现场的演示视频就是一个遭遇车祸的用户因为手机紧急功能获救的故事(嗯,在苹果那边这样的故事很多)。

WearOS看起来也正在拓展生态,会上提到了一些第三方App的拓展。

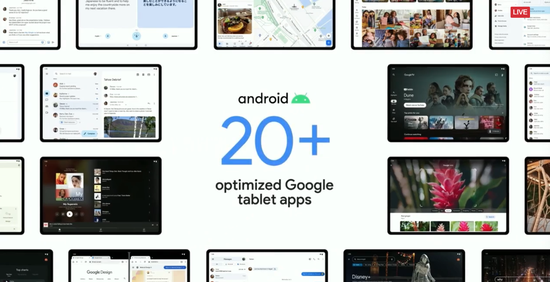

谷歌也终于重新开始重视平板了,大屏设备得到了进一步优化,小米平板等在会上还录了一小脸。谷歌也承诺更新20多种自己的应用,让它们在大屏幕上效率更高。

实际上,谷歌对平板的重新重视,不只因为近期安卓平板硬件的重新兴起,更因为折叠屏的出现。

后者展开后实际就是平板的新形态,小米等厂商也在努力推进平板生态。此前在安卓阵营,平板生态一直是短板,第三方App大多就是手机App直接方法显得粗制滥造。

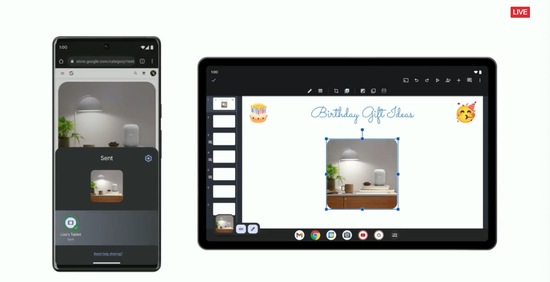

手机和平板两者也逐渐开始互融互通了:例如手机取图,平板编辑。

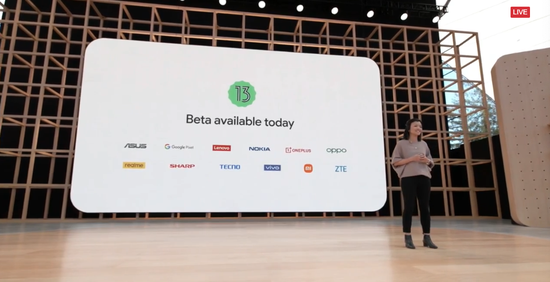

最后,Android 13 beta版将于今天发布。注意这张图,除了谷歌,诺基亚,夏普,屏幕上的终端厂商全部都来自中国。

谷歌自有品牌硬件发布

“亲儿子”系列终于到来,首先是谷歌Pixel 6a,它是旗舰Pixel 6的“青春版”,依旧是谷歌自研芯片Tensor ,也依旧支持5G,还有Android 13系统。这意味着核心体验跟旗舰Pixel 6一致。

外观设计类似,但看起来没那么高端(应该是塑料材质),背后是1200万像素的双镜头系统,价格更低了只要449美元起。7月21日预售,7月28日上市。

这款手机跟之前所有Pixel手机一样,是Android系统和刚才讲那一大票谷歌个各种AI技术和算法的硬件体现;或者说是谷歌各种技术的躯壳。

配合Tensor芯片算力,则能让这些效果达到最佳,比如实时翻译功能。

回到现在,还有个旗舰耳机发布。

Google Pixel Buds Pro,名字很长,Pixel Buds系列终于有了支持主动降噪的耳机,定价199美元。

内部也是一套定制的音频芯片,具备7小时主动降噪,11小时非降噪的续航。

还支持谷歌全家桶多点连接,切换过程类似苹果。甚至还有谷歌版的空间音频。

自曝三连发

因此除了刚才发布的一个廉价手机和高级耳机。今天更吸引目光的环节,是谷歌官方自曝未发布的手机,手表,平板三大系列产品。

手机:Pixel 7和Pixel 7 Pro,铝合金的外壳看起来更高级,芯片采用下一代Tensor。但其他信息未透露。

手表:Pixel Watch,外观更圆润,材质更高端。是Pixel 7和Pixel 7 Pro的好搭档。

这手表还跟谷歌之前收购的智能手表公司Fitbit做了整合,把一些列健康功能带到自己手表上。

平板,明确要在2023年发布,相应匹配已经在谷歌开发者社区开始了。模样看起来像三星的产品,但后背很圆润,三个触点意味着它应该可以外接键盘。

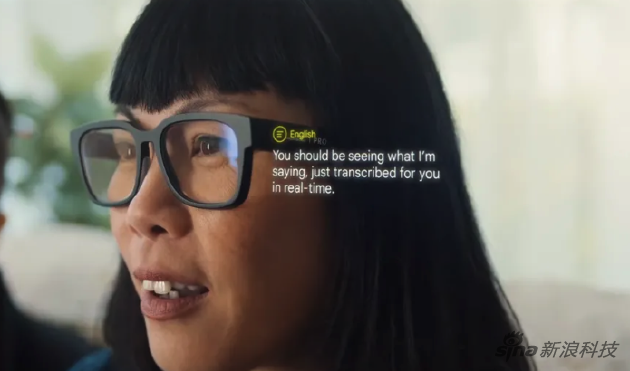

对了,在展示视频中,出现了一款类似AR眼镜的东西。但这个看起来更像是个概念产品。而不是官方自曝的内容。

该公司没有分享它们何时可用的任何细节,只是在一段录制的视频中展示了它们,实际上并没有展示它们,或者你将如何与它们互动。但是视频中显示的内容描绘了一幅非常酷的关于潜在 AR 未来的图景。

总结:

跟往年谷歌I/O一样,这次主题演讲的大半内容依旧晦涩难懂,除了专业技术人士,普通观众对LaMDA等概念难以理解。

但这些恰好是彰显谷歌在AI方向深厚技术实力的部分。 今年以搜索作为线索,几乎将所有技术和成果进行了串联,只是演示过程略显平淡,没有往年“AI给餐馆打电话订餐”那样惊艳的片段。

跟往年谷歌I/O不同的是,今年的硬件不算少,不只有可以近期买到的手机和耳机新品,还有官方任性的自曝过程。

此前,谷歌Pixel产品往往尚未发布已经被外界曝光,可以说毫无秘密可言。这次干脆官方自己来,不让中间商赚差价。