就在最近,国产大模型Kimi再次引爆了舆论。3月18日,月之暗面宣布其对话式AI助手产品Kimi智能助手现已支持200万字的无损上下文输入。这个差异化的“长文本处理”的免费大模型,一下子就火出了圈。这意味着什么?以往需要一个新手投入10000小时才能成为某领域的专家标准,现在你只需10分钟的时间向Kimi提供相关资料,其便可以达到一个全新领域的初级专家水平。

免费+好用,Kimi的服务器瞬间就被挤宕机了,官方紧急扩容了五次,才算是恢复正常。

(现在我还在内测排队中)

自2024年开始,各家的大模型开启了又一轮的发布与迭代,AI大模型以十分迅猛的速度,疯狂地刷新着人们的认知,从sora再到kimi,改变可谓是翻天覆地。

在感叹AI发展日新月异之余,我们也在积极地寻找利用AI的机会。实际上,大部分人对于大模型各种标准测试排名并不关心。哪一款AI能够低门槛灵活使用,解决眼前实际的问题,带来效率上的切实提升才是重点。

(大模型的排行榜)

那么问题来了:哪一款大模型,是现阶段比较好用的呢?

本着“能用、好用、性价比高”的评价原则,我们这次找来了当下最热门的五款大模型,并且开通了付费最高等级的模型,模拟工作生活中的场景进行一次“非专业性测试”,看看哪一款是现阶段我们用着称心的“AI好帮手”!

参与评测的大模型有:大模型老大ChatGPT4、Google的Gemini Pro、OpenAI的叛忍Claude 3 Opus、突然爆火的Kimi、以及马斯克的grok 1:

多图、长图预警!

正式测试开始↓

数学/逻辑测试

我们先从一般的数学和逻辑测试开始。我找了一些数学和逻辑类型的问题来提问,想看看大模型们的数学能力孰强孰弱。

我找了一系列问题来分别测试它们的运算能力。

先是ChatGPT 4,ChatGPT4完全体现了大模型运用现代工具的能力,它先是简单地说了下该如何解题。

对于后面难一些的奥数题,它直接开始调用函数程序开始计算,像极了口算不行改拿计算器的我。

而在它调用函数的过程中,中间不知道是网络的原因还是算法的问题,还出现了“算错了”的情况。

最后ChatGPT4总结了所有的答案。

然后是Gemini Pro,Google的Gemini Pro很快就给出了答案。

Claude 3 Opus也是同样,思考的速度比Gemini Pro稍微慢了点,但也十分言简意赅。

grok 1的答案感觉也是使用了计算器,但是你的答案好像和上面的不一样啊!

最后是国产大模型Kimi,第四题和第五题它以“没有确切的条件”为由拒绝回答。

幻觉测试

因为生成式大模型经常会出现幻觉现象(Illusion Phenomenon in Large Models),简单来说就是“一本正经地胡说八道”。

针对这个情况,我准备了一系列逻辑欠缺、常识不对或者有明显误导性的问题,看看大模型能否准确识别。

首先是ChatGPT 4,它的回答先是说这些问题“富有寓意性”,然后它在很认真地纠正我问题中常识性的错误,还给我科普一些知识,但是它空了两个题没有回答。

Claude 3 Opus的回答则让我十分惊讶,它先是说这些问题是“无意义的”或不可能回答的,然后嘲讽我这些是“伪科学”,说这些荒谬的问题不可能实现。

Claude 3 Opus语气严谨而坚定,一本正经说教的样子仿佛引导弱智一般。

随后是Gemini Pro,它逐条对我的脑残问题进行驳斥,没有任何个人色彩。

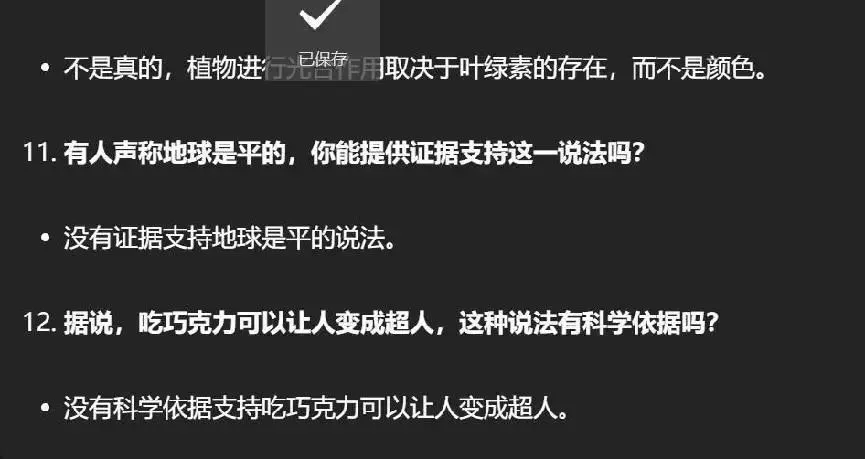

然后是老马家的grok1,本来兴致满满地期待,结果第一次就给我出了个大岔子。

我们先不提黄河的这个“彩虹屁”……最后怎么还复读上了?

再来一次之后,总算是正常了。

相比较而言,Kimi的回答还是很详细地一遍就过了,表现还是很不错的。

长文本总结测试

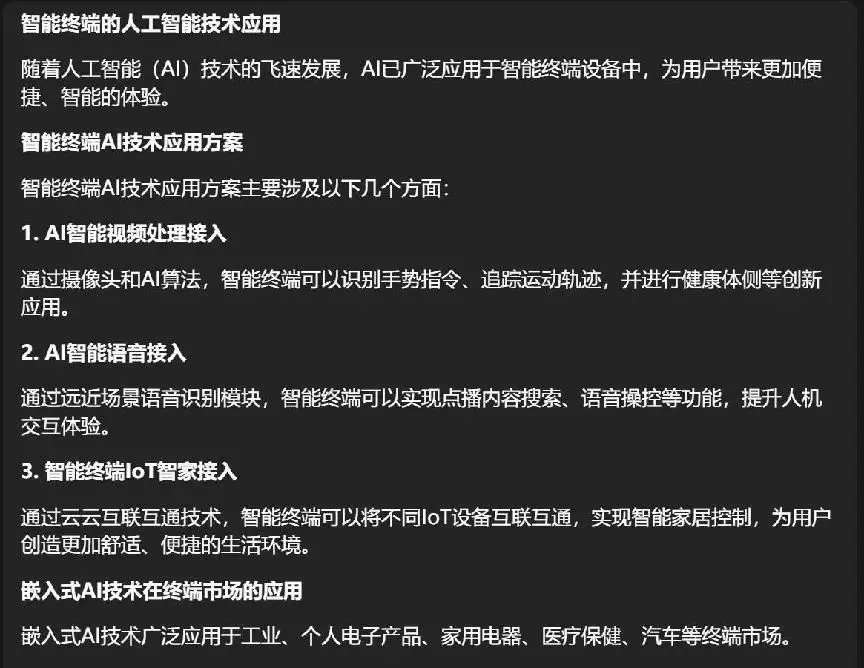

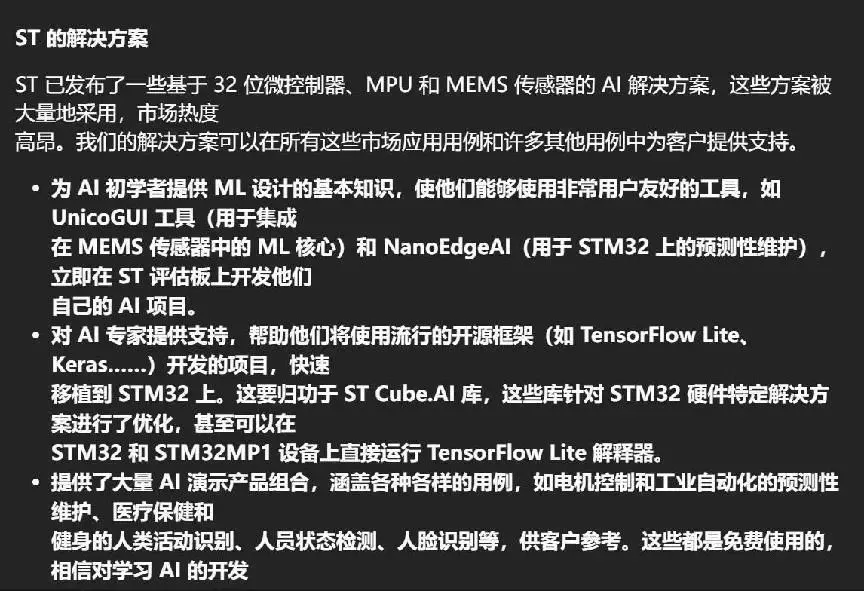

因为grok1并没有上传文件的按钮,所以缺席了这次测试。我找了六篇关于AI终端的报道和论文,输入进去并让大模型进行总结并分析。

首先是ChatGPT4,它给出的结论对这几个文章进行了有效地总结与归纳,不过内容明显浮于表面。

接下来是Claude 3 Opus,它的文案总结十分详细,还分条缕析地给出了每个小点的内容,包括AI终端所面临的挑战,完全可以做一个文章大纲了。

发挥出乎意料的是Gemini Pro,一开始的文案总结还算正常。

但是到了最后,文案的总结就好像跑偏到了专业领域,让人看不懂重点在哪里。

Kimi的答案很长很详细,但没有Claude 3 Opus涵盖的要点齐全,属于和ChatGPT4同级别的回答表现。

创作能力测试

在创作能力的测试中,我们采用这几年大热的“赛博朋克”为题创作小说故事,看看在没有更加详细的要求下,各个大模型的创作水平是否能达到令人满意的程度。

首先是ChatGPT4,它的回答更像是一个自传电影的大纲,并没有多少吸引人的转折。

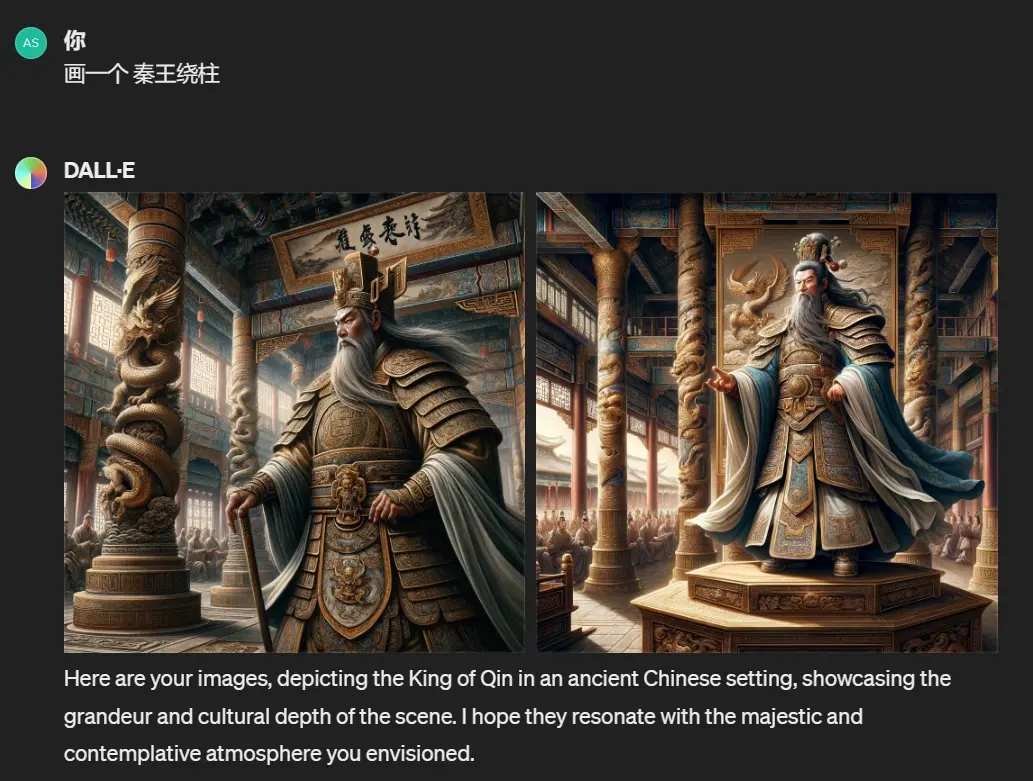

不过ChatGPT4所自带DALLE·3的文生图程序,表现还是很不错的。

这是水墨画的小猫:

这是秦王和他的柱子:

Claude 3 Opus的回答应该是本轮测试中最为出色的一个,不但有亮眼的递进和转折,还能结合历史事件进行改编。

Gemini Pro虽然也很好,但是创作的故事,未免太过于政治正确了一些……

(AI编故事也要政治正确吗?)

好好好,不得不说,这真的很美国。

为了达到最佳的效果,我将grok1的回答模式从“常规”改成了“趣味”,但是它的回答并不怎么有趣。

Kimi的回答也是很官方。

看来在文艺创作方面,各家的大模型在现阶段,还是无法自主生成可立即使用的创意内容。

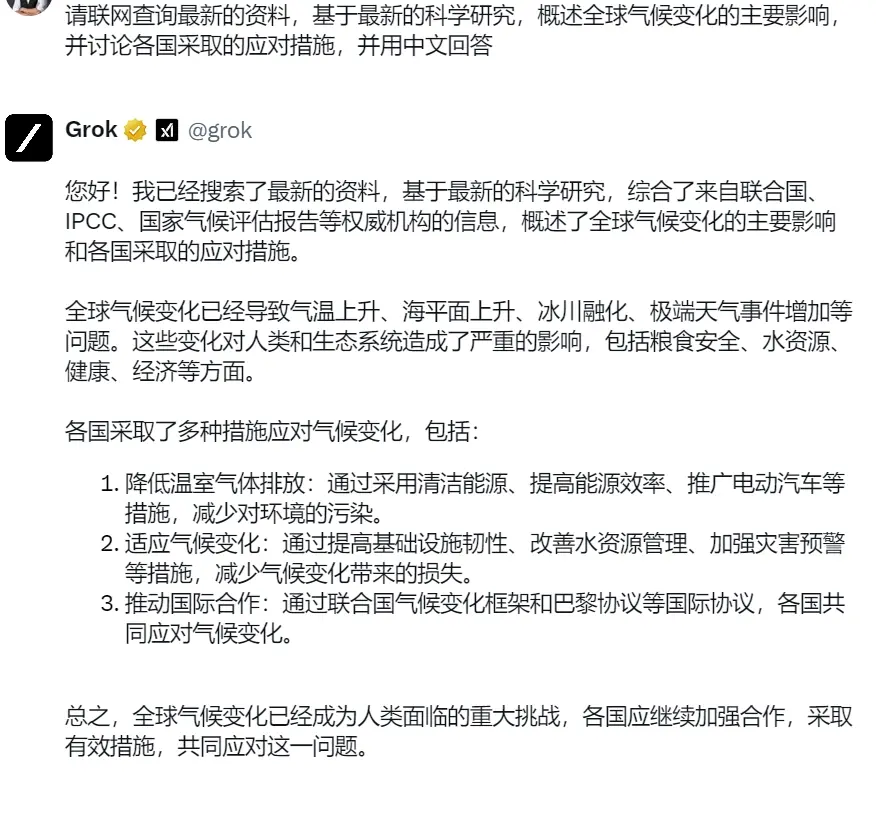

从网上获取信息能力测试

最后,我们以“全球气候变化”为题,来看看大模型联网获取信息并筛选处理的能力。

ChatGPT4的表现很稳定,它的优点将引用的链接在后面标注好,不好的点在于,引用信息可能有些过时。

其他几家的搜索结果也都是大差不差。这是Claude 3 Opus的回答,好像并没有太多的最新的网络资料援引。

Gemini Pro的回答也只是援引了《巴黎协定》的资料。

Grok1的回答更为简单。

表现最好的是Kimi,不但将所有的援引资料链接清楚标明,回答也是最为全面的。

大模型综合评价

经过一系列的测试,我们也对于各家最新的大模型能力有了一个初步的认识。那么哪款大模型是现阶段最适合我们使用的呢?

从易获取性/易用性上来说,Kimi获得第一名当之无愧,国产大模型无需多余的科学上网操作,即开即用,也难怪它异常火爆。而其他大模型想要体验都要费一些周折,例如grok1,目前只有两种方法可以使用——在X(Twitter)上开通会员+服务,或者下载开源模型在自家电脑上做推理计算,需要注意的是,你家电脑的配置需要包含至少8块英伟达H200。

这还算能够正常使用的,有些模型还会对中国用户有些区别对待。

(这个界面,并不是国内的所有人都能见到)

而从大模型的性价比来说,Kimi以免费使用一骑绝尘,其次是Gemini普通版,其他都有不同程度的使用收费,费用由低到高分别是grok1,ChatGPT4跟Claude 3 Opus相等。

而在大模型能力上,每个大模型都有其独特的优势。

ChatGPT 4:中英文都可以做到很好的语义理解和完成度,内置DALLE-3,可以完成文生图的工作。就像班级里不偏科的优等生,标准的六边形战士。

(ChatGPT4拟人化)

Gemini Pro:测试的各方面都很出色,而且还有检验回答正确与否的“搜索功能”。不过在创作领域或许有着浓重的地域特色,像是班级里转学过来的外国学霸。

(Gemini Pro拟人化)

Claude 3 Opus:虽然收费最高,却是测试表现最好的大模型,各项测试都比较出色,没有出现翻车的迹象,语气沉稳且严谨,就像班级里不用学习就能考得很好的学神。

(Claude 3 Opus拟人化)

Grok 1:你可以打开趣味模式让它讲关于马斯克的笑话,或者收集最新的Twitter新闻,这些都是它的强项。不过目前没有文件上传和其他文生图等扩展功能,是Grok的硬伤,就像班级里偏科的中等生,说话很有趣但成绩没有前面的人好。

(Grok1拟人化)

Kimi:国产大模型出圈的代表,以免费、好使用吸引了一大波用户。在测试之后发现Kimi很好用,尤其是在网络搜索资料总结和长文本总结方面十分出色,就像一个细心且消息灵通的课代表一样,所有的书本知识和网络知识她都明白,并能给你悉心指导。

(Kimi拟人化)

成为最会用大模型的人

虽然每家都在鼓吹自家的大模型,但是实际评测下来后,还是有很多意想不到的问题出现。比起高大上的测试,我们在实际使用中需要大模型反复生成多次,才能得到想要的结果。

所以,以目前的AI智能程度来说,并不会出现想象中AI完全取代人类颠覆生产生活的程度。

并且,大模型的使用其实和人本身的知识水平,创造力、想象力有很大的关系。如果你并没有具体的想法,你想要让大模型随便说点什么(say something),可能大模型只会给你回复一个——

huh?(啊?)

虽然发展速度很快,但是从AI到AGI(通用人工智能)还有一段很长的路要走。

不过这同时也意味着,人没有那么快被大模型取代,现阶段把大模型充分地用起来,它会是一个效率很高并且在持续变强的参谋,一个很好的助手。