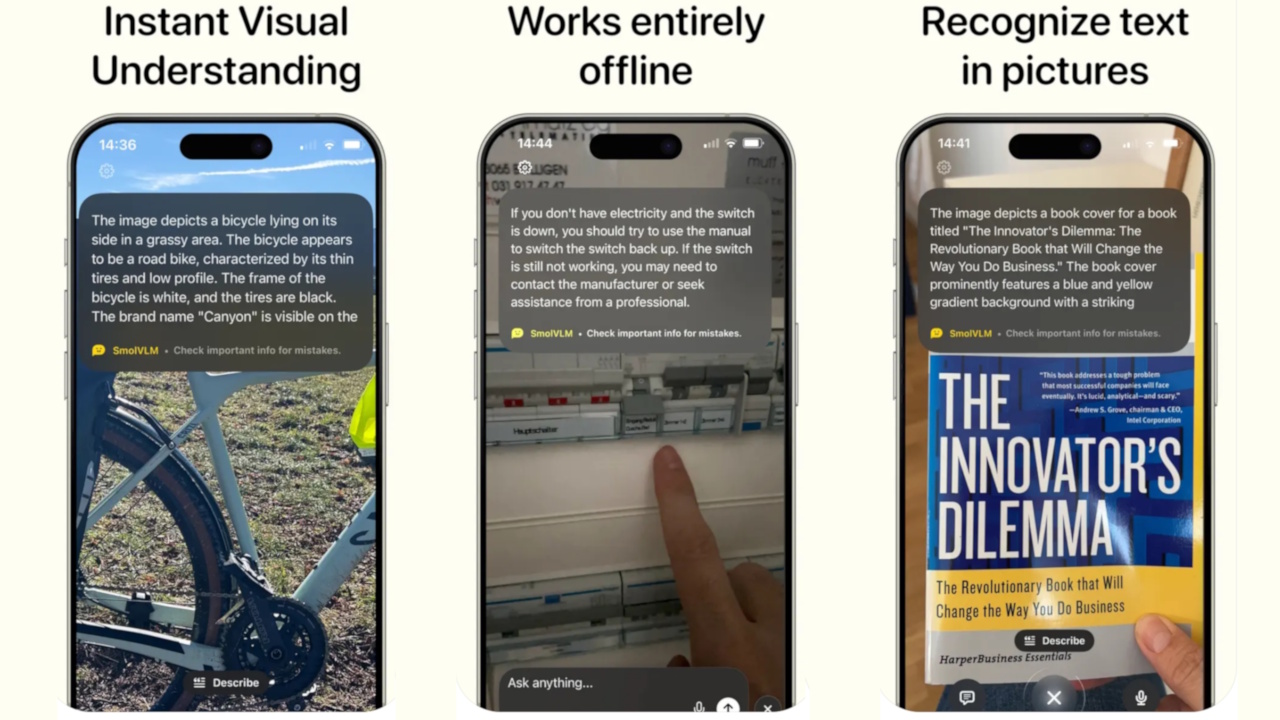

人工智能初创公司 HuggingFace 日前在 Apple App Store 推出名为 HuggingSnap 的新应用,该应用的主要功能是调用 iPhone 摄像头查看周围的事物,用户可以进行任意提问例如识别物体、解释场景、阅读文本等。

该应用最大的特点就是不需要将数据发送到云端,HuggingSnap 应用使用 HuggingFace 内部的视觉模型 smolvlm2 来实时分析手机看到的内容。

用人工智能配合摄像头进行实时物理识别并不是新鲜事,ChatGPT 等应用已经提供类似功能,但 HuggingSnap 的特点在于完全基于本地 AI 模型进行计算。

HuggingFace 表示:HuggingSnap 可以离线工作、节省电量并在手机上处理所有数据,该应用在购物、旅行、学习或只是探索周围环境时非常有用,HuggingSnap 为您的 iPhone 带来智能视觉 AI。

实际上该应用的用途非常广泛,例如帮助儿童了解周围的物体、帮助爱好者了解花草树木、帮助视觉障碍者播报和描述周围的物体等等。

只是 smolvlm2 模型在本地运行那么必然对算力有要求,HuggingFace 并未提到机型限制,或许是这个模型经过优化已经可以在 iPhone 上运行。

另外该应用不仅支持在 iOS 18 + 系统上运行,还支持在 macOS 15.0 + 系统上运行,但仅限于搭载 Apple M 芯片的 Mac,不支持搭载英特尔 CPU 的 Mac,最后还支持 visionOS 2.0+。